腾讯微信 AI 团队推出新型扩散语言模型 WeDLM 提升文本生成能力

腾讯微信 AI 团队发布了一种新型扩散语言模型框架 ——WeDLM(WeChat Diffusion Language Model)。该模型的设计旨在突破传统大型语言模型(如 GPT 系列)在并行推理效率方面的限制,提供更高效的文本生成能力。

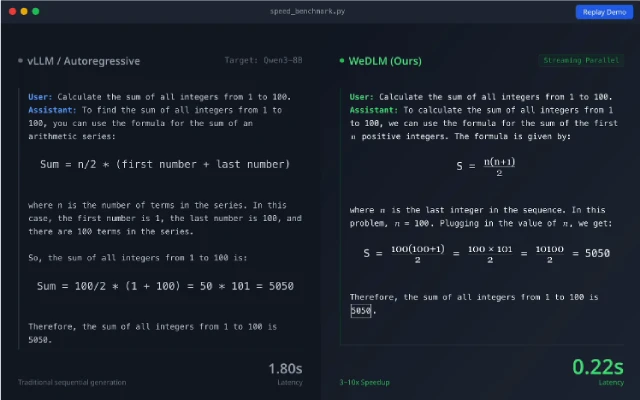

WeDLM 通过创新性的拓扑重排技术,将扩散模型与标准因果注意力机制相结合。这种融合使得 WeDLM 能够兼容 KV 缓存技术,从而有效解决了传统扩散模型由于双向注意力而导致的推理速度限制。这一改进不仅提升了推理速度,还在生成质量方面也得到了有效保证,特别是在处理复杂推理任务时,表现得尤为突出。

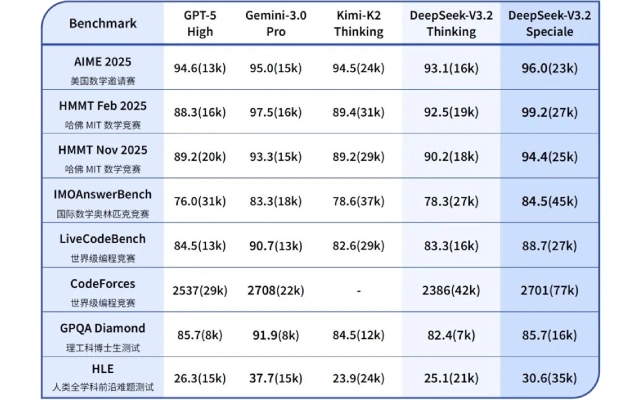

在实际性能测试中,WeDLM 展现出显著的速度优势。例如,在数学推理任务 GSM8K 中,WeDLM-8B 模型的推理速度比经过优化的自回归模型(如 Qwen3-8B)快了约 3 倍,而在低熵场景的计数任务中,速度提升甚至可达到 10 倍以上。同时,在多个基准测试(如 ARC、MMLU、Hellaswag)中,WeDLM 的生成质量与传统自回归基线模型相比,表现相当或更为优异,表明其不仅在效率上有突破,同时也保持了较高的准确性。

WeDLM 的高效推理能力使其适用于多种场景,包括智能客服、代码辅助生成和实时问答等。随着其在实际应用中的推广,WeDLM 有望降低计算成本,提高用户体验,推动 AI 技术的更广泛应用。

以上关于腾讯微信 AI 团队推出新型扩散语言模型 WeDLM 提升文本生成能力的文章就介绍到这了,更多相关内容请搜索码云笔记以前的文章或继续浏览下面的相关文章,希望大家以后多多支持码云笔记。

如若内容造成侵权/违法违规/事实不符,请将相关资料发送至 admin@mybj123.com 进行投诉反馈,一经查实,立即处理!

重要:如软件存在付费、会员、充值等,均属软件开发者或所属公司行为,与本站无关,网友需自行判断

码云笔记 » 腾讯微信 AI 团队推出新型扩散语言模型 WeDLM 提升文本生成能力

微信

微信 支付宝

支付宝