认识服务器硬件:CPU、主板、内存、SSD、HDD、GPU

AI 概述

本文面向高校科研场景科普HPC服务器硬件知识。服务器专为高强度运算设计,区别于普通电脑,具备多路处理器、大容量内存及专业散热,是流体、AI训练等科研的“发动机”。文章详解了CPU(调度大脑)、内存(ECC校验工作台)、SSD/HDD(高速缓冲与冷存储)、GPU(并行加速器)等核心部件的作用与选型要点。重点强调硬件搭配需遵循“黄金法则”:CPU与内存通道、GPU与PCIe带宽需匹配,存储应分层设计,并预留充足供电散热余量,以确保科研计算的稳定性与效率。

目录

文章目录隐藏

在高校科研中,涉及流体、分子动力学、第一性原理、大气及 AI 大模型训练等高性能计算(HPC)场景中,服务器就是科研工作的“发动机”。很多老师、博士后、博士生在接触超算或自建集群时,都会被各种硬件名词绕晕:CPU、GPU、内存带宽、NVMe SSD……它们在服务器里扮演什么角色?今天我们就用一篇入门级科普,把服务器硬件拆开讲给你听。

一、服务器是什么?它和普通电脑有啥区别?

简单来说,服务器是为持续、稳定、高强度运算而设计的计算机系统,通常具备:

- 多路处理器(当前是双路居多,就是 2 颗,AMD EPYC™ 9965 双路可达 384 核心,旗舰方案,售价在 20 万);

- 大容量高带宽内存(基本上当前单条内存 16G 起步,双路最少插根 32G~数 TB);

- 高速存储阵列(SSD 固态作为系统盘+缓存盘+HDD 作为存储方案);

- 专业散热与供电(7×24 小时稳定运行,可考虑 UPS 不间断电源);

- 支持并行计算和网络扩展(集群方案和并行网络设计,具体看需求)。

普通电脑追求单核性与性价比,而服务器更在意算力密度、可靠性、扩展性——这也是科研中跑大规模仿真、深度学习训练的前提。

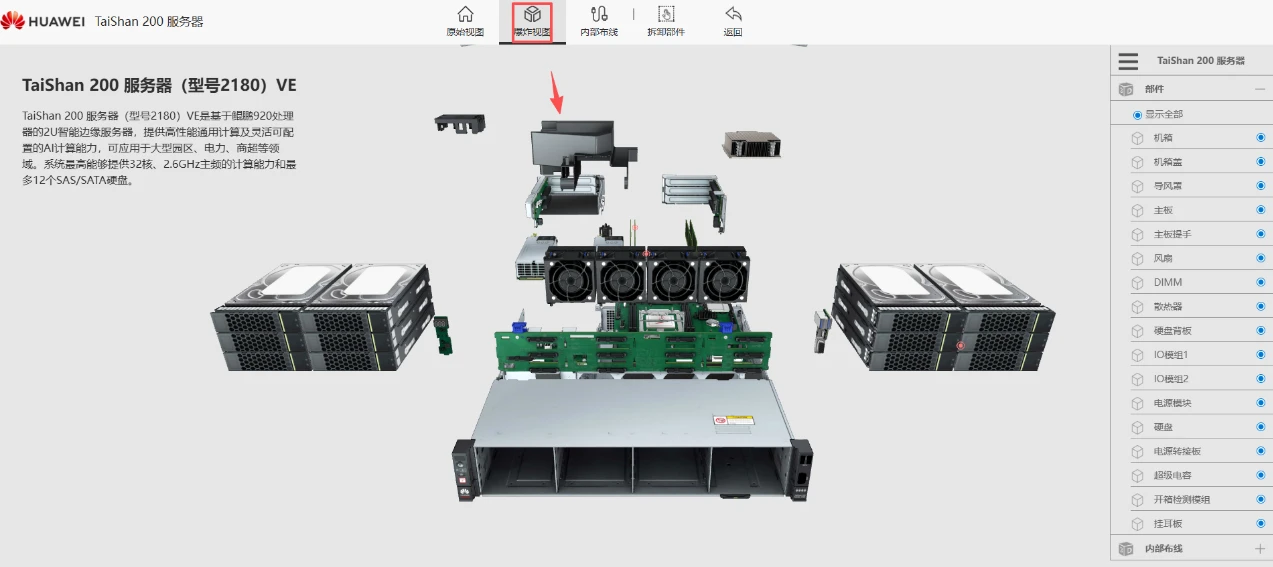

服务器设备拆解 3D 动画示意图:

二、核心硬件逐个看

CPU —— 服务器的“大脑”

- 作用:负责通用计算任务,包括操作系统运行、程序逻辑控制、部分并行计算。

- 特点:

- HPC 服务器常用Intel Xeon或AMD EPYC系列,核心数最大可达 384 核,支持多线程(SMT)。

- 支持ECC 内存校验(自动纠错,防止数据损坏,科研计算非常重要)。

- 科研场景:分子动力学、有限元分析、传统

CFD模拟等任务往往先由 CPU 进行任务调度与串行部分计算。

温馨提示:选择 CPU 要看核心数、主频与内存通道数的匹配度,盲目追高主频可能浪费多核潜力,尤其在并行计算任务中,如果是注重单核心性能的 COMSOL 和 MATLAB 软件的话,则优先考虑主频,但是核心也应该保持在 24 核心以上。

主板:硬件的“交通枢纽”

- 作用:承载 CPU、内存、扩展卡,并提供数据传输通路。

- 特点:

- 服务器主板多为EATX/SSI EEB 大板型,插槽多(支持多路 CPU、多条 PCIe)。

- 配备IPMI/BMC 远程管理芯片,可在关机状态下监控温度、电压、远程开机。

- 科研场景:主板决定了你能装多少 GPU、多大内存,以及未来扩展空间。

内存(RAM):临时数据的“工作台”

- 作用:存放正在运行的程序和数据,CPU 直接从中读取,速度远高于硬盘。

- 特点:

- HPC 服务器内存容量从 64GB 起步,大型集群节点可达 512GB~2TB。

- 采用ECC DDR4/DDR5,可检测并纠正单位错误,保证长时间计算的准确性。

- 内存通道数影响带宽(如 8 通道比 4 通道快近一倍)。

- 科研场景:处理海量网格数据、加载大型模型参数时,内存不足会直接导致任务崩溃。

固态硬盘(SSD):高速数据的“缓冲区”

- 作用:快速读写临时文件、缓存数据、加速程序启动,注重读写速度。

- 特点:

- 常用NVMe PCIe Gen4/Gen5 SSD,顺序读速可达 7GB/s 以上。

- 寿命以 TBW(总写入字节)衡量,科研高频读写需选企业级型号(如 Intel D7-P5520、三星 PM1735)。

- 科研场景:大规模数据预处理、检查点保存(checkpoint)频繁的任务,SSD 可显著缩短 IO 等待时间,如果生信方向的固态要留有足够大空间,以备内存不够用时,作为虚拟内存使用。

机械硬盘(HDD):大容量数据的“仓库”

- 作用:长期存储原始数据、计算结果、备份文件,数据安全处理,组建 RAID5,10 等。

- 特点:

- 容量大(单盘可达 20TB+),成本低,但读写速度慢(150MB/s 左右)。

- 服务器常用SAS 接口硬盘(比 SATA 更稳定耐用)并配合 RAID 冗余。

- 科研场景:气象观测数据、基因测序原始文件等体积巨大且访问不频繁的数据,适合放在 HDD 阵列。

GPU:并行计算的“加速器”

- 作用:擅长大量相同运算的并行处理,比如矩阵乘、图像处理、深度学习训练。

- 特点:

- HPC 常用NVIDIA A100/H100、AMD MI250等专业卡,显存可达 80GB,支持 NVLink 高速互联。

- 相比 CPU,GPU 在浮点运算性能上可高出数十倍。

- 科研场景:AI 大模型训练、分子对接模拟、三维渲染与可视化几乎离不开 GPU。

温馨提示:GPU 选型要结合显存大小与计算精度需求(FP32/FP16/BF16),并注意服务器电源与散热能否支撑满负载功耗。

三、硬件搭配的“黄金法则”

在 HPC 项目中,硬件不是孤立存在的,它们之间必须平衡与匹配:

- CPU 与内存通道匹配:更多内存通道才能发挥多核 CPU 的吞吐能力。

- GPU 与 PCIe 带宽匹配:高算力 GPU 需要足够的 PCIe 通道,否则数据供给跟不上。

- 存储分层设计:热数据走 SSD,冷数据走 HDD,兼顾速度与成本。

- 供电与散热预留余量:满负载运行时功耗可能远超空闲状态,必须提前规划。

以上关于认识服务器硬件:CPU、主板、内存、SSD、HDD、GPU的文章就介绍到这了,更多相关内容请搜索码云笔记以前的文章或继续浏览下面的相关文章,希望大家以后多多支持码云笔记。

声明:本文来自互联网用户投稿,该文观点仅代表作者本人,不代表本站立场。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。

如若内容造成侵权/违法违规/事实不符,请将相关资料发送至 admin@mybj123.com 进行投诉反馈,一经查实,立即处理!

重要:如软件存在付费、会员、充值等,均属软件开发者或所属公司行为,与本站无关,网友需自行判断

码云笔记 » 认识服务器硬件:CPU、主板、内存、SSD、HDD、GPU

如若内容造成侵权/违法违规/事实不符,请将相关资料发送至 admin@mybj123.com 进行投诉反馈,一经查实,立即处理!

重要:如软件存在付费、会员、充值等,均属软件开发者或所属公司行为,与本站无关,网友需自行判断

码云笔记 » 认识服务器硬件:CPU、主板、内存、SSD、HDD、GPU

微信

微信 支付宝

支付宝